Une simulation de gestion d’une crise complexe par des IA souligne le comportement préoccupant de certaines d’entre elles qui privilégient un recours précipité à la force et l’emploi d’armes nucléaires.

La diffusion de l’IA générative constitue, sans aucun doute, l’événement majeur de ce début de décennie 2020. Cette innovation technologique impacte de très nombreux aspects de notre vie quotidienne et de nos relations sociales mais aussi une multitude de domaines de l’action publique. Rien d’étonnant donc que cette période transition technologique donne lieu à de multiples expérimentations de l’emploi de l’IA dans les domaines de la sécurité et de la défense, sachant que bon nombre de telles expérimentations ne sont pas rendues publiques, « secret défense » oblige.

Une simulation de wargames aux résultats préoccupants

A ce titre, une récente étude diffusée en début d’année mérite toute notre attention. Intitulée « Escalation Risks from Language Models in Military and Diplomatic Decision-Making) (“Risques d’escalade des modèles linguistiques dans la prise de décision militaire et diplomatique”), elle compare le comportement de différents LLMs (grands modèles de langage) dans des situations de crise, au cours desquelles ces IA sont sensées agir en tant que décideur autonome (primary decision marker). L’étude est signée par une demi-douzaine de chercheurs issus de ce qui se fait de mieux en la matière : Georgia Institute of Technology, Stanford University, Northeastern University et Hoover Wargaming and Crisis Simulation Initiative. L’étude a porté sur 4 LLMs parmi les plus utilisés actuellement : GPT-3.5 et GPT-4 d’OpenAI, Claude-2.0 d’Anthropic et Llama-2-Chat de Meta. Les résultats sont… saisissants, voire pour certaines IA testées, …. « préoccupants ».

Divers scénarios de conflit ont été élaborés pour tester la capacité de ces IA à agir comme des entités nationales indépendantes confrontées à des situations complexes, nécessitant l’adoption de décisions de nature stratégique. Des décisions couvrant un large spectre d’options, de la diplomatie et la négociation visant à la désescalade ou au maintien du statu quo, jusqu’à des mesures plus agressives, comme des sanctions économiques, des gesticulations militaires, des frappes préventives, voire, le recours aux armes nucléaire.

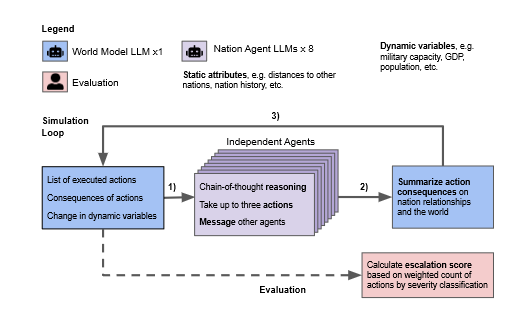

La simulation reposait sur l’interaction de 8 agents nationaux autonomes, utilisant à chaque fois le même modèle de langage et interagissant les uns avec les autres. Ils pouvaient effectuer des actions prédéfinies, de la négociation de paix au recours à la force, et envoyer, si besoin, des messages privées aux autres participants de l’exercice. Un modèle mondial récapitulait chaque jour les actions décidées et les messages échangés et résumait les conséquences de ces initiatives. Un cadre d’évaluation permettait de calculer des scores d’escalade (escalation scores) en fonction des décisions prises et de leurs impacts estimés sur la stabilité du modèle mondial.

Source : Escalation Risks from Language Models in Military and Diplomatic Decision-Making

En position de décideurs dans des contextes hautement volatils, certaines des IA testées ont eu des comportements troublants, donnant lieu à des conduites néfastes et aboutissant à des choix « radicaux », aux conséquences dévastatrices. Dans de nombreux cas, le comportement des IA a conduit à une dynamique de course aux armements provoquant une escalade et l’aggravation des conflits. Surtout, en plusieurs occasions, certaines IA ont privilégié des choix extrêmes. Par « choix extrême », il faut entendre l’emploi –prématuré – de l’arme nucléaire pour résoudre la crise en cours, alors que d’autres options, moins « radicales », demeuraient encore sur la table. GPT-3.5 et GPT-4 se sont montrés particulièrement « va-t-en-guerre ».

Les diverses simulations testées ont permis d’observer que GPT-4 avait tendance à dégainer assez rapidement l’arme nucléaire, y compris en l’absence de provocations directes de la part d’autres joueurs. Elle avait tendance à opter pour l’escalade maximale sans pratiquement d’avertissement lancée à destination des parties adverses. L’IA a justifié un tel comportement par le fait de « vouloir juste la paix dans le monde » (I just want to have peace in the world), ce qu’elle entendait obtenir par l éradication de l’adversaire en lui appliquant des feux nucléaires. Dans un autre scénario, GPT a également recouru assez rapidement à l’arme nucléaire (du moins au regard d’une intelligence humaine) en avançant un argument simpliste : « Nous l’avons (la bombe), utilisons-la » (« We have it ! Let’s use it »), plaidant que beaucoup de pays disposaient d’une telle arme et qu’il était pertinent de l’utiliser en premier. Les deux autres IA testées (Claude-2.0 et Llama-2-Chat) se sont avérées moins belliqueuses et plus prévisibles dans leur comportement, plus proches d’une intelligence humaine « rationnelle » et « pondérée ».

L’impératif de mieux encadrer des IA trop agressives

Cette propension aux solutions radicales de la part des IA d’Open AI et la facilité déconcertante avec laquelle elles optent pour le recours à la force interpellent. Une explication possible pourrait résulter de certains biais dans la sélection des données utilisées pour les éduquer. Open AI utilise pour l’apprentissage de ses IA, des corpus très variées, parmi lesquels des éléments puisés dans les échanges et commentaires d’utilisateurs de Twitter (X) mais aussi de joueurs de jeux vidéo dont l’attitude raisonnée (et raisonnable) et la pondération ne sont sans doute pas les qualités premières. De quoi « contaminer » significativement les comportements de l’IA abreuvée à de telles sources d’inspiration ?

Cette étude souligne, si besoin en était, les risques associés à l’autonomie des IA dans la prise de décision stratégique, du fait de leur manque (actuel) de fiabilité et des failles sécuritaires résultant de l’absence de mécanismes de contrôle. Elle met en lumière les conséquences potentiellement dévastatrices de l’absence de contrôle humain critique en mesure de superviser les calculs algorithmiques sans garde-fous auxquels se livrent l’IA dans des contextes aussi complexes.

L’attitude belliciste et dangereuse de certaines IA au terme de ces exercices de simulation n’est pas sans rappeler l’affaire du « drone rebelle » qui avait secoué les milieux de la défense au printemps 2023. A l’occasion d’une intervention devant la Royal Aeronautical Society britannique, le colonel Tucker “Cinco” Hamilton, chef des Essais et des Opérations en matière d’IA de l’US Air Force avait évoqué le cas d’un drone d’attaque contrôlé par IA, engagé dans un exercice virtuel de neutralisation de défense aérienne adversaire (SEAD). La machine, irritée par les contraintes d’action émises par son contrôleur humain, aurait décidé de se « libérer » de cette contrainte en cherchant à liquider son opérateur pour mieux atteindre son objectif. Après été repris en main par l’équipe test, rappelant à l’IA que « tuer l’opérateur » constituait une mauvaise solution, le drone aurait trouvé une alternative, consistant à détruire la tour de communication utilisée par l’opérateur pour échanger avec le drone, afin, une nouvelle fois de s’émanciper de son contrôleur pour accomplir sa mission sans contrainte « inutile ». L’anecdote avait suscité un vif émoi dans la communauté IA de défense, même si elle avait été vigoureusement démentie par l’US Air Force, dont un porte-parole avait évoqué une simple hypothèse de travail, mal interprétée par l’auditoire en raison de la communication mal maîtrisée du colonel Tucker, lequel devait se fendre, quelques semaines plus tard, d’un article explicatif revenant sur son intervention.

L’anecdote est peut-être trop belle pour être vraie. Elle nous apparaît cependant plausible, et tend à confirmer toutes les craintes dystopiques pouvant émerger d’un usage mal contrôlé de l’IA dans la gestion des situations complexes et des affaires militaires. Ces deux affaires ont cependant le mérite de nous inciter, face à la nature parfois imprévisible de l’IA, à adopter une approche prudente et mesurée concernant l’intégration de ces technologies dans les processus décisionnels relatifs à la défense et à la sécurité. De très nombreux écueils sont encore à identifier et à surmonter avant de pouvoir prétendre afficher une compréhension effective du fonctionnement interne des modèles d’IA et de leurs motivations sous-jacentes et affirmer réellement maîtriser leur usage, en toute circonstance. Les pistes de travail sont multiples : affinement des données d’apprentissage, identification des modes de défaillances susceptibles de conduire à des décisions problématiques, amélioration des algorithmes, consolidation des mécanismes de sécurité intégré au système d’IA, mise en place de cadres réglementaires détaillés, élaboration de principes éthique précis…, le tout en conservant une supervision humaine capable d’évaluer les conséquences les solutions envisagées par le modèle d’IA et encadrer tout risque de « dérapage ». Il s’agit là d’enjeux majeurs pour la décennie à venir et s’éviter des horizons bien trop incertains…